【Unreal Engine×Sofdec事例インタビュー】バーチャルプロダクションでのMV撮影で求められる精緻な動画再生を実現

2022年1月に公開され、その再生数は125万にものぼるミュージックビデオ「飛翔するmeme」。

花譜さんとたなかさんが歌い、パフォーマンスを披露するこの動画には、CRIWARE(シーアールアイウェア)の動画技術が活用されています。製作したHibino VFX Studioに、メイキングと背景について伺いました。

【組曲】花譜×たなか #95「飛翔するmeme」【オリジナルMV】

―自己紹介と御社のご紹介をお願いします。

他にも、音響・映像機器のセールスやコンサート音響サービスを担当している部署もあります。

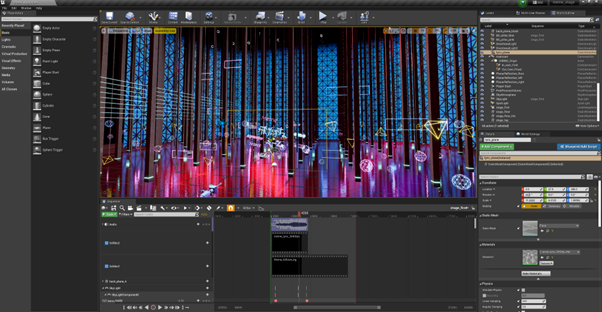

Unreal Engineとメディアサーバーdisguise。今回使用した技術とは?

―今回の要となる技術、disguiseについても教えてください。

disguiseは1台で4Kを4つ出力できるというメリットがあるため、大画面に対しての出力に優れています。

―disguiseという実態はLEDそのものというよりも、端末や機器を接続したメディアサーバーという認識が正しいのでしょうか。

複数のマシンで負荷を分散できるため、映像を滑らかに出力しやすくなります。

―Unreal Engineを活用した利点について教えてください。

現実に近い光の反射を使った映像を、忠実な映像を確認しながら作ることができます。

もうひとつの利点は、disguiseがUnreal Engineの機能「nDisplay」をうまく活用してくれることです。

※「nDisplay」はUnreal Engineが提供するプラグイン。巨大な映像を分割し、複数のディスプレイへの出力を支援する機能。

Unreal Engineの採用前は、主に2D環境で製作された映像のLED出力がメインでした。

―採用に関して参考にした事例はありましたか?

―国内で同様の環境を構築し、試みをしている会社はありますか ?

disguiseを用いて撮影できるスタジオはいくつかありますが、大画面を使用したVirtual Productionとして運用している会社は国内にはないですね。

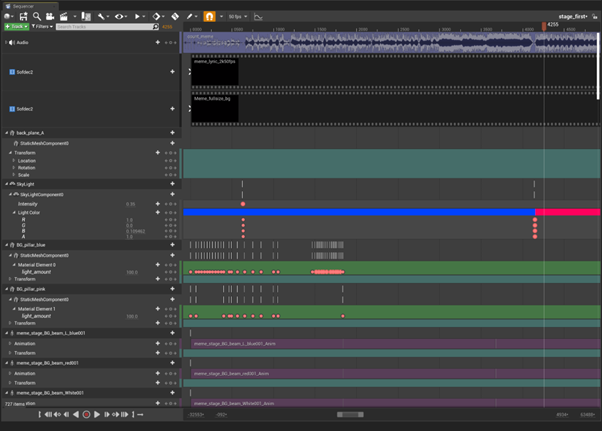

動画再生ミドルウェア「CRI Sofdec」を活用したMV製作と撮影

―今回の映像は、CRIWAREの映像再生用ミドルウェアSofdecを使用して製作されています。Sofdecを知ったきっかけはどのようなものでしたか。

―ミドルウェアを探していたということは、従来のシステムでは表現において困っている部分があったということですか

システム上、ひとまず50fpsを目指していましたが、それに満たないと視覚的にもシステム的にも不具合が出てしまいます。

様々な動画変換形式でのテストがうまくいかないなか、Sofdecなら実現できそうだと。

―最終的に動画はどのような仕組みで作られましたか?

演者さんには、さらにその前で歌詞を背負ってパフォーマンスしていただきました。

―歌詞動画の加算合成は企画段階から行う予定でしたか?

―他にSofdecで使用した機能はありますか?

シーク後の遅延やカクつきがなかったので、リアルタイムな撮影を阻害することなく使用できたのが良かったです。

―MVの撮影にはシークが非常に重要だったということですね

―Unreal Engine側で構成した処理はありますか?

「RedSpy」というトラッキング機器の情報をdisguiseに送り、disguiseとUnreal Engineのカメラ位置を同期させていました。

CineCameraActor(※映像撮影用のカメラオブジェクト)をブループリントで制御し、ポストプロセス(Unreal Engineの映像補正機能)をかけています。

―Sofdecを使用した動画を実際に組み込む際に困ったこと、戸惑ったことはありましたか?

他の映像ツールではどこから導入したらいいんだろう、という導線が分かりづらいものもありましたが、Sofdecは導入手順が分かりやすく、サポート対応の安心感も違っていました。

―今回導入にあたって、CRIWAREのサポートチームに対応を依頼したのはどんなことでしたか?

サポート相談からヒントを得て、プログラムや映像をさらに改良できた部分もあります。

―導入から収録にかかった時間はどれくらいでしたか?

一度か二度変換をかけてUnreal Engineに取り込めば、再生まで想定どおりの動きになりました。大きく困った部分はなかったため、撮影の流れを崩さずにワークフローが形成できました。

―撮影した映像はあとから編集や修正が加えられているのでしょうか?

たなかさんも背景の映像を確認しながら歌ったり、パフォーマンスしたりできるため、撮影側・演者さん共に作用し作品づくりのクオリティが上がっていると思います。

―演者さんも自分がどういう世界にいるかというのを感じながら撮影できるのが利点ですね

撮影側としても演者さんの位置を確認しながらカメラアングルを決められる利点もあります。見たままに撮れるので、撮影後の作業も楽になっているはずです。

disguise、Sofdecを連携したシステム。今後の展望は?

―今回のMVに対して伺ってきましたが、今後このシステムを活用する構想はありますか?

他にも背景反射が重要になる、車のプロモーションなどでも使用していただけます。

Unreal EngineでどうしてもFPSが伸びないという場合に、たとえば遠景だけを動画で処理するという軽量化ソリューションのひとつとしても有効です。

―近距離のオブジェクトをリアルタイムレンダリングで処理し、遠距離のものをプリレンダリングの動画におきかえる、という手法ですね。

LEDディスプレイの環境は平面の映像とは違いRがついている(曲がっている)形になっているため、2D素材をそのまま貼り付けてもパースが合わなくなってしまいます。そういった場合にUnreal Engine上に配置し3Dデータとして扱ってあげることでパースをあわせ、正確な見た目を再現することが可能になります。

―Sofdecでは動画の結末を複数用意しておき、再生を分岐させる機能もありますよね。

映像製作において実写の2D素材は必要になってくるため、LEDを用いた3DCGとの合成はどのような分野でも、必要になってくるものかと思います。